深入了解网站的Robots文件(Robots文件的作用和使用方法)

![]() 游客

2023-10-29 13:54:01

129

游客

2023-10-29 13:54:01

129

在互联网上,每个网站都有自己的特色和规则。其中,Robots文件是一个非常重要的文件,它可以控制搜索引擎爬虫在网站上的行为。本文将深入介绍Robots文件的作用和使用方法。

什么是Robots文件?

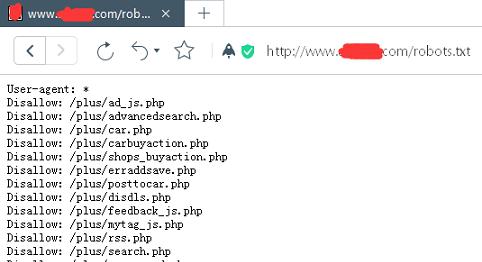

Robots文件是一个文本文件,它通常放置在网站的根目录下。这个文件包含了一些指令,告诉搜索引擎爬虫哪些网页可以被索引,哪些网页不可以被索引,哪些网页可以被跟踪,哪些网页不可以被跟踪等。

Robots文件的作用是什么?

Robots文件的作用是让搜索引擎爬虫更好地了解网站的结构和内容。通过Robots文件,网站管理员可以控制搜索引擎爬虫的行为,避免一些不必要的抓取和索引,同时也保护了网站的安全性和用户的隐私。

Robots文件的语法格式是怎样的?

Robots文件的语法格式比较简单,它由一系列的指令和参数组成。其中,最常见的指令包括User-agent、Disallow、Allow、Sitemap、Crawl-delay等。这些指令可以在Robots文件中任意组合使用。

如何编写Robots文件?

编写Robots文件需要了解每个指令的含义和使用方法。通常情况下,我们可以通过一些在线工具生成Robots文件,并将其放置在网站的根目录下。当然,也可以手动编写Robots文件,并使用FTP工具上传到网站服务器上。

Robots文件有哪些常见的误区?

在使用Robots文件的过程中,很多人容易出现一些误区。比如,认为Disallow指令可以完全阻止搜索引擎爬虫访问某个网页,其实不然。Disallow只是建议搜索引擎爬虫不要访问某个网页,并不能完全阻止。

如何测试Robots文件?

测试Robots文件是否生效可以使用一些在线工具,比如GoogleSearchConsole。通过这些工具可以检查Robots文件中的指令是否正确,并查看搜索引擎爬虫的行为是否符合预期。

如何更新Robots文件?

当网站发生变化时,需要及时更新Robots文件。比如新增了一些页面或改变了网页的访问权限。更新Robots文件可以手动编辑或使用一些工具来生成新的Robots文件。

Robots文件对SEO有哪些影响?

Robots文件对SEO有着重要的影响。通过合理编写Robots文件,可以控制搜索引擎爬虫的行为,有利于提高网站的排名和用户体验。同时,也能够降低一些恶意爬虫对网站的攻击。

本文详细介绍了Robots文件的作用、语法格式、编写、误区、测试、更新以及对SEO的影响等方面。希望能够帮助读者更好地理解和使用Robots文件,提高网站的品质和价值。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自火狐seo,本文标题:《深入了解网站的Robots文件(Robots文件的作用和使用方法)》

标签:文件

- 搜索

- 最新文章

- 热门文章

-

- 网站如何在本地推广?有哪些有效的本地推广策略?

- 抖音纯剪辑原创怎么做?有哪些技巧和注意事项?

- 抖音动漫短视频剪辑技巧有哪些?如何快速上手?

- 图表视频网站分析怎么做?如何优化网站分析效果?

- 网站爬虫怎么分析?分析网站爬虫的正确方法是什么?

- 快手换装视频剪辑怎么制作?步骤和技巧是什么?

- 常用的html编辑器有哪些?如何选择适合自己的编辑器?

- 竞品分析网站怎么用?如何有效利用竞品分析工具进行市场研究?

- 改版网站怎么才能不被k?改版后如何避免搜索引擎惩罚?

- 怎么建立一个营销型网站?需要哪些步骤和技巧?

- 新建的网站如何运营推广?有哪些有效的推广策略?

- 唯品会如何在网站推广?有哪些有效的推广策略?

- HTML实例自己做有哪些?如何通过实例学习HTML?

- 网站浏览量怎么分析?如何通过数据提升网站流量?

- 如何利用微博做网站推广?有哪些高效策略?

- 网站关键词的优化怎么弄?有哪些有效策略?

- 博客网站怎么做网页链接?如何优化提高SEO效果?

- 网站关键词推广如何做大?有效策略和常见问题解答是什么?

- 如何自己搞网站推广卖货?有哪些有效策略和常见问题解答?

- 石岩如何通过网站推广?有哪些有效策略?

- 热门tag

- 标签列表

- 友情链接